Crisis de reputación: Facebook permitió contenido potencialmente violento y desinformación

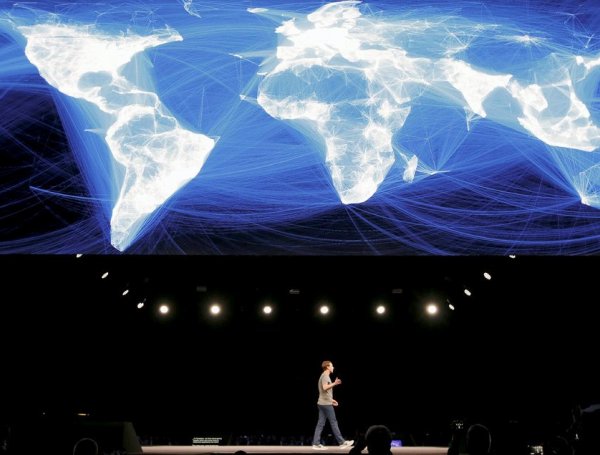

Facebook se ha convertido en un aprendiz de brujo al que el éxito se le va de las manos. La revelación de documentos internos de la red social según los cuales sus ejecutivos permitieron por acción u omisión la publicación de desinformación y contenido polémico se ha vuelto como un bumerán contra la compañía. Estas informaciones le han ocasionado la peor crisis de reputación de su historia, que ya acarreaba episodios oscuros en torno a la privacidad de los datos como el de Cambridge Analytica.

Igual que las tabacaleras en su día, o la farmacéutica que fabricó el medicamento responsable de la grave crisis de opioides en EE UU ―todas negando la posibilidad de la adicción―, Facebook se enfrenta al gran momento de la verdad: el de que, tras la idílica comunidad global que ha pretendido crear, ha contribuido a dañar la convivencia por ignorar contenido potencialmente violento como discursos de odio en países donde esos mensajes pueden tener graves consecuencias, según se desprende de las revelaciones de documentos.

La constatación del descuido no sólo se aplica a los EE UU de Donald Trump, con el apogeo de las fake news gracias a las redes sociales y consecuencias tales como el asalto al Capitolio del 6 de enero, o el aún reducido porcentaje de vacunación contra la covid-19 por culpa de teorías acientíficas a las que Facebook ha contribuido a dar pábulo. La falta de control de la tecnológica sobre sus contenidos también ha hecho estragos en la India, al potenciar la política de rehinduificación del país por parte del nacionalista Narendra Modi. O en Myanmar, atizando la persecución de la comunidad rohinyá. También en Afganistán, Yemen o Etiopía.

Así se desprende de la última tanda de documentos internos filtrados a un consorcio de medios internacionales, conocidos ya como los papeles Facebook. Un tema central es determinar si el propio funcionamiento de la plataforma ha originado el problema; es decir, si las herramientas que han hecho de Facebook lo que es ―el botón de like y el de compartir contenido, tan intuitivos― han multiplicado exponencialmente el riesgo en ausencia de una adecuada moderación de las publicaciones.

Las revelaciones, basadas en entrevistas a antiguos empleados e informes internos, constatan cómo la expansión global de la compañía ―presente en más de 190 países y más de 160 idiomas, con más de 2.800 millones de usuarios al mes― descuidó el control del contenido a causa, en muchos casos, de un número insuficiente de moderadores con adecuado conocimiento del idioma y el contexto locales para identificar publicaciones potencialmente peligrosas ―o cuando menos dudosas― en numerosos países en desarrollo; en 2019, además, la empresa recortó su presupuesto para contratar a moderadores, en favor de las máquinas.

Las filtraciones también revelan que los sistemas de inteligencia artificial (IA) que Facebook emplea para impedir dicho contenido a menudo no son eficaces, pero tampoco las herramientas para el posible aviso de un usuario. La descripción arroja un Facebook hipotéticamente blindado a las denuncias, al que se suma, además, la carta blanca concedida a unos cinco millones de perfiles, considerados usuarios VIP, para los que las reglas de moderación sencillamente no existirían, como adelantó el mes pasado el diario The Wall Street Journal. Entre los usuarios importantes se hallarían conspicuos representantes de la alt righ estadounidense y del círculo más íntimo de Trump, como quien fuera su estratega, Steve Bannon, y conocidos blogueros y portales informativos en su órbita.

La hipotética manga ancha de Facebook -casi siempre en favor de políticos y planteamientos conservadores, como demuestran los casos de EE UU y la India- adquiere un carácter más peliagudo en países donde el riesgo de la inestabilidad y la violencia es real. En una revisión publicada el año pasado en el foro de mensajes interno sobre los métodos para identificar excesos, un empleado informó de “brechas significativas” especialmente en Myanmar -el papel de Facebook propalando el discurso de odio que azuzó el genocidio rohinyá se demostró ya en 2018- y Etiopía, una de cuyas regiones, Tigray, vive un conflicto civil cada vez más cruento. La criba de los algoritmos “clasificadores”, que detectan contenido inadecuado, se reveló inútil en el escrutinio de mensajes en los idiomas o dialectos hablados en la antigua Birmania o Etiopía; en este caso, con abundantes amenazas de muerte.

Las brechas de seguridad de Facebook se resumen en cuatro: la incapacidad lingüística de entender, y por ende moderar, millones de publicaciones de usuarios en países de habla no inglesa; la incomprensión de sus propios algoritmos; la inacción a la hora de intervenir allí donde los programas de IA no llegan (según un informe de marzo, la compañía sólo adopta medidas entre el 3% y el 5% de los casos de discursos de odio, y en el 0,6% de las publicaciones de contenido violento); y un palpable descuido, desidia incluso, en vísperas del asalto al Capitolio; de hecho, la compañía desactivó ciertas salvaguardas de emergencia impuestas para las elecciones de noviembre de 2020, y tuvo que activar rápidamente algunas cuando la violencia estalló el 6 de enero. La incapacidad de abordar la actividad online de las hordas trumpistas causó malestar en el seno de la compañía.

Los documentos filtrados pertenecen a la confesión de Frances Haugen, exejecutiva de Facebook, el gigante tecnológico que más rápidamente -en solo 17 años- ha superado la cota del billón de dólares de valor de mercado, según Bloomberg. Haugen ha comparecido este lunes ante un comité del Parlamento británico, dos semanas después de hacerlo ante el Congreso de EE UU. Portavoces de la compañía han intentado minimizar el golpe a su reputación subrayando, en un comunicado, que nunca ha puesto el beneficio por delante de la seguridad o el bienestar de la gente. Antes, al contrario, “hemos invertido 13.000 millones [de dólares] y tenemos más de 40.000 empleados dedicados solo a una cosa: garantizar la seguridad de la gente en Facebook”.

El presupuesto de las grandes tecnológicas en software, hardware y servicios de IA podría alcanzar los 342.000 millones de dólares este año, según International Data Corp. Dicho gasto en IA va camino de superar el listón de los 500.000 millones en 2024, según la misma fuente.

La confesión de Haugen y el resto de exempleados de Facebook coloca al gigante tecnológico frente a sus demonios, tras haber podido remontar en parte una ofensiva judicial por prácticas monopolísticas. Igual que en su día las tabacaleras de EE UU, o la farmacéutica responsable de la crisis de opioides por sus agresivas campañas de marketing -y el engaño manifiesto de que el fármaco no causaba adicción-, Facebook parece, según la información filtrada, haber priorizado la monetización sin dotarla de salvaguardas; despreciado la seguridad -incluso la integridad física de muchas personas- por hacer caja. Según el exresponsable para Oriente Próximo y Norte de África, los objetivos de crecimiento global fueron “coloniales”, en el sentido de favorecer a cualquier precio la hegemonía y el dominio sobre millones de súbditos digitales. Más del 90% de los usuarios activos de Facebook viven fuera de EE UU y Canadá.