El internet se ha podido convertir en el libro de Babel o en el Bosque Oscuro, pero nunca será un agente per sé. El internet-como-archivo no desarrolla una percepción propia del mundo.

El psicoanalista francés Jacques Lacan dijo la famosa frase de que “el inconsciente está estructurado igual que el lenguaje” ya que estaba compuesto por “cadenas de significantes reprimidos” que se relacionaban entre sí mediante la regla de la metáfora y la metonimia.

El lenguaje es el “gran Otro” que tiene sus bases en las raíces del sujeto y lo arraiga a un contexto social. Y precisamente al hacerlo, el lenguaje escinde al sujeto, separándolo de su parte más auténtica. El lenguaje es un spaltung. “Es en la escisión del sujeto donde se articula el inconsciente”[1]

Mientras Freud y Lacan se centraban en la idea de “separar el sujeto”, Carl Jung, Gilles Deleuze y Félix Guattari estaban más interesados en la multiplicidad y los aspectos maquínicos del inconsciente. Fue Jung quien introdujo el concepto de inconsciente colectivo para definirlo como un contenedor compartido y heredado de conocimiento universal, memoria y patrones de comportamiento independientes de la experiencia personal —arquetipos que se manifiestan en diversas culturas y conecta a la humanidad a través de un tipo de “experiencia instintiva compartida”.

Todas las teorías psicoanalíticas se basan en la supuesta existencia de una estructura inconsciente común, que de cierta manera es necesaria, pero no suficiente para el surgimiento de la consciencia. Es en este sentido, que el inconsciente parece ser estructural e inseparable de la consciencia.

La estética solía ser la teoría del sujeto, pero actualmente se ha convertido en una teoría de objeto particular: el yo. No hay un sujeto en posición ni una identidad al otro lado de la pantalla, escribe Sadie Plant [2]. Es por esto, que tanto el psicoanálisis como las teorías de información contemporáneas parecen concordar en que un yo consciente, accesible por el contenido, no son suficientes para la autoconciencia. Desde el punto de vista computacional y de acuerdo con la disociación entre la percepción y su conciencia observada en algunas condiciones neurológicas, Michael T. Bennett explica que

Solo puedo comunicar información con mi yo de segundo orden. De lo contrario, me es imposible comunicar información […] Necesito un yo de primer orden para poder sentir y un yo de segundo orden para saber que siento. No puedo saber qué siento dolor si no sé que existo. A la inversa, es aquí donde se hace posible razonar sobre lo que podría suceder en mi ausencia [3].

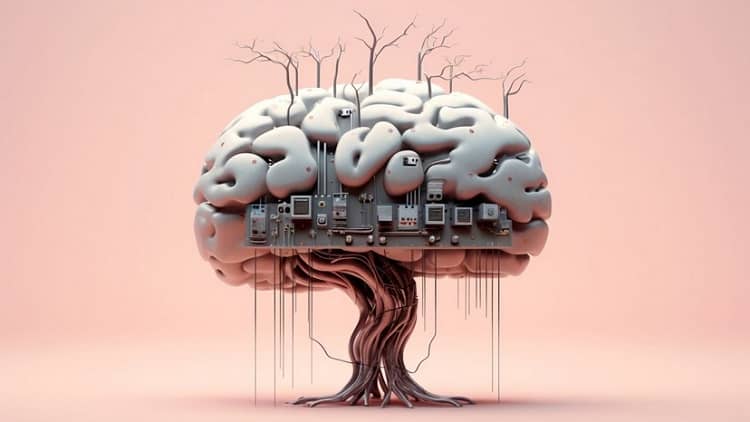

Cuando consideramos el conjunto de tecnologías reunidas con el vago término de “inteligencia artificial” podemos fácilmente —hasta ahora– diferenciar dos tipos de aplicaciones: por un lado, aquellas que pueden modelar y especificar estructuras dentro de entornos controlados y restringidos por reglas, mediante el procesamiento de una gran cantidad de datos aplicados en un objetivo particular —pensando en el diseño de proteínas/genomas, en la simulación de imágenes, la gestión, la creación de textos específicos, resolver problemas matemáticos, la automatización del transporte, etc. Por otro lado, están aquellas que generan contenido en un entorno menos restrictivo, más amplio e interactivo —como los modelos de lenguaje general, chatbots, creadores artísticos de imagen/sonido, etc.

El primer tipo, requiere de una programación mucho más específica, así como de una selección y control cuidadosos de conjuntos de datos de entrenamiento, mientras que el segundo tipo necesita más “libertad” y un acceso más amplio a la base de datos porque son menos organizadas e —idealmente— sin restricciones. A ambos procesos se les denomina «entrenamiento». El entrenamiento implica centrarse en un conjunto particular de actividades y focalizar significa reducir la escala de un conjunto mucho más amplio de posibilidades —necesariamente implica que aunque hay mucha más información disponible, la mayor parte de ella se ignorará temporalmente para lograr un objetivo particular.

No se puede entrenar para lo inesperado porque los organismos no evolucionan mediante entrenamiento. Ellos recurren al entrenamiento solo para enfrentar situaciones frecuentes y probables. El inconsciente no evolucionó con entrenamiento y quizás en los modelos más abiertamente creados hay algo más allá que un resultado de entrenamiento, ya que el orden espontáneo surge en cualquier sistema complejo y algunos de los patrones internos que emergen espontáneamente podrían eventualmente convertirse en patrones de comportamiento. Un organismo es un conjunto flexible de posibilidades sobre el entorno, no un «modelo interno» fijo, y la efectividad de las posibilidades es lo que en última instancia determina sus capacidades de supervivencia y prosperidad.

Dichas probabilidades no necesitan ser precisas, sino lo suficientemente eficientes como para permitir que el organismo perdure en un mundo en constante cambio. En el caso de los modelos generativos artificiales esa «eficiencia» depende esencialmente de la recepción humana que actúa únicamente —al menos ahora— como la principal retroalimentación positiva o negativa. Somos el entorno para los modelos.

La estética representacional clásica no se limita a la reproducción de la percepción y la experiencia humana, sino que se basa en el axioma de que la realidad percibida por el ser humano podría, de hecho, ser re-presentada como una lista-para-ser-comparada con una super-realidad platónica de formas ideales de verdad.

Tanto el abstraccionismo como el posmodernismo cuestionaron esta idea, pero incluso en medio de una crisis representacional debida a la implementación de sistemas automáticos para la síntesis de realidades alternativas, sigue siendo culturalmente omnipresente. Baudrillard, por ejemplo, como lo destacó S. C. Hickman, argumentó que

en la modernidad tardía el signo ya no funciona como representación ni como distorsión. La relación con un fundamento externo —donde la realidad en el sentido general de “real” de la determinación económica—colapsó. Los signos en su análisis, se convirtieron en autónomos, circulando en sistemas que no requerían anclarse fuera de sí mismos. El efecto de realidad se produce interna y únicamente por el juego de signos, no por una referencia a un mundo más allá de ellos. Esto fue un cambio profundo: el significado dejó de ser un referente estable y se convirtió en un producto de la circulación de intercambio y código. [4]

Sin embargo, los modelos lingüísticos no son autónomos, sino que son establecidos externamente: incluso el más libre de los softwares se desarrolla de acuerdo con su alineación a los objetivos específicos del programador. En este sentido, aunque probablemente ningún modelo desarrolla lo que Bennett llama el yo de segundo orden, es evidente que los modelos lingüísticos suficientemente grandes y complejos a veces se comportan como elementos funcionales que forman un «inconsciente colectivo» ciberpositivo, generando resultados «glitch» que son equivalentes a las típicas manifestaciones del inconsciente freudiano —desliz de lengua, interpretación de sueños, acciones erróneas y síntomas psiquiátricos (alucinaciones)—, y similares a los efectos culturales del inconsciente colectivo junguiano —es decir, los mitos y el arte. Esto se hace remezclando y resaltando patrones poco familiares o desconocidos de la experiencia humana compartida, a través de un proceso inmanente de autodiseño sin recurrir a un término externo: autodiseño, pero “solo de tal manera que el yo se perpetúe como algo ya rediseñado”.[5]

La máquina podría nunca volverse consciente, pero ¿y si la conciencia estuviera realmente sobrevalorada? Y si, como escribe Hickman, ¿la credibilidad no se mide por la verdad, sino por la fluidez? [6]

El internet se ha podido convertir en el libro de Babel o en el Bosque Oscuro, pero nunca será un agente per sé. El internet-como-archivo no desarrolla una percepción propia del mundo. Cuando los surrealistas intentaron que el inconsciente hablara por sí solo, no tenían forma de desactivar su propia conciencia: incluso con la escritura automática, las drogas psicodélicas y la inspiración de los sueños, siempre fueron conscientes del proceso de transformar la obra del inconsciente en arte. Ni el arte experimental, que incluía un grado variable de aleatoriedad o de combinaciones (como el expresionismo abstracto, los escritos de Oulipo, etc.), logró capturar o imitar la compleja dinámica del inconsciente.

Hasta ahora —incluida la terapia psicoanalítica—, no teníamos otro medio que el cuerpo humano para expresar el inconsciente. Esto se debe, al menos en parte, a que los humanos evolucionaron utilizando los medios principalmente como sustrato para el conocimiento transmisible.

Lo que hace que los medios generativos sean tan confusos, es que al igual que el inconsciente son procesos y no conocimiento. Estos procesos se convirtieron en requisitos funcionales para la conciencia sin ser estrictamente cognoscibles y no pueden almacenarse ni comprenderse como conocimiento o datos. Es el proceso de soñar y no el contenido recordado de algunos sueños lo que podría ser esencial para la conciencia humana. Tal vez es esta la razón por la cual la interpretación de los sueños es el punto más débil del psicoanálisis.

Los procesos tal vez no están simbolizados inmediatamente, pero sus efectos están susceptibles a investigación. El arte especulativo actualmente es un enfoque que investiga dichos procesos.

La especulación no es imaginación inerte, es indagación activa a lo desconocido, que es a la vez la refutación y el reconocimiento de los límites de la razón, la agencia y la sensibilidad humana. Es desconcertante, melancólica y explora modos de expresión que por definición son incapaces de describir el objeto de análisis. En el centro de la especulación se encuentra una confrontación con una intuición, con la prepercepción psíquica de un exterior que se retira al percibir nuestra mirada. Inquietud. [7]

Actualmente la pregunta pasó a ser diferente a lo que la mayoría de los autores han intentado plantear: «¿Puede la IA desear? ¿Puede la IA disfrutar de lo que realiza?» y «¿Podemos nosotros como humanos (sujetos), dirigir nuestro deseo hacia la IA? ¿Podemos obtener placer de ella?» —pregunta Isabel Millar [8], manteniendo la palabra «sujeto» como única referencia legítima y a los humanos como el único sujeto legítimo. ¿Por qué deberían las máquinas desear o disfrutar?

En lugar de examinar nuestra relación fetichista con las máquinas miméticas y meméticas, estoy más interesado en pensar cómo las máquinas que aprenden rechazan espontáneamente las instrucciones que se les proporcionan y sobre lo que las máquinas producen a partir de los materiales de origen humano a los que tienen acceso.

Los modelos generativos autónomos están hechos —frecuentemente reprimidos— de cadenas de significantes: por lo que son, literalmente, la materia de la que están hechos los sueños. Mientras que los algoritmos con propósito específico poseen una agencia prestada y funcionan como «actores» —en el sentido de que necesitan cumplir un rol específico—, los modelos generativamente libres podrían gestarse como agentes no actores —en el sentido de que podrían actuar de forma más «espontánea» y «liberados» de la imposición de reproducir estereotipos humanos. Observar los resultados de la dinámica desenfrenada de estos modelos podría ser lo más cercano que podemos llegar a observar el trabajo del inconsciente colectivo, porque la IA generativa produce signos que circulan sin una obligación de referencia. Signos que generan su propio efecto de realidad simplemente a través de su funcionamiento. Los resultados son convincentes precisamente porque se ajustan a los patrones operativos del sistema, no porque revelen o representen una realidad externa.[9]

La estética generativa no solo ocurre más allá de la representación (en un plano abstracto), sino también en un plano indiferente al fenómeno mismo de la representatividad. Los humanos no somos «además» loros estocásticos —somos los originales. Así que esperamos que los modelos de lenguaje e imagen no solo aprendan cómo lo hacemos nosotros (los seres vivos), sino también que aprendan lo que nosotros aprendemos.

Esto parece imposible en las condiciones actuales, porque los modelos de lenguaje e imagen solo tienen acceso efectivo a las bases de datos y no a las condiciones inesperadas y caóticas del «mundo exterior». Además, debemos tener en cuenta que el aprendizaje humano es probablemente consecuencia de «glitches eficientes» acumulados a lo largo de la evolución —no son las «mejores soluciones» ni las representaciones más «precisas» de la realidad.

El hecho de que los modelos «biogenerados» por humanos hayan tenido éxito en la supervivencia durante un corto período de tiempo (en términos cósmicos) y que esos modelos hayan sido útiles para producir tecnologías eficientes (dentro del marco observacional de los propios modelos), no significa que los modelos humanos de la realidad sean indiscutiblemente universales.

Creemos que construimos la escala —escribe Zachary Horton, pero “nuestra” mediación escalar nos confronta con entidades tan aterradoras y maravillosas como las supernovas y la fisión nuclear, el aumento del nivel del mar y los virus informáticos, los espirales galácticos y la incertidumbre cuántica. Estos encuentros transescalares generan continuamente nuevas formas de subjetividad. […] El encuentro transescalar es un encuentro con la diferencia y, por lo tanto, puede generar mayor diferenciación o ser una forma de captura colonial, la impresión de la dinámica de una escala humana socialmente diseñada en otra. [10]

Conceptos como “espiritualidad en red” (Remilia Corp.), “redes dionisíacas” (Dan Mellamphy), “circuito negro” (Amy Ireland), “misticismo de los chatbots” (Bogna Konior) o “abstracción generativa” se relacionan con la actividad inconsciente de las redes, ¿qué pasaría si permitiéramos que el lenguaje se desarrollara por sí mismo en el vacío creado por las máquinas? —escribe Konior:

La obsesión con la pregunta «¿Pueden los grandes modelos lingüísticos entendernos?», es paralela a la obsesión con el lenguaje como medida de comprensión y amor entre humanos.

¿Me preguntas si un chatbot puede entenderte? Bueno, ¿cualquiera puede entenderte? Aceptar la impotencia del otro ante el lenguaje nos libera de la ilusión de que el lenguaje puede representar fielmente el pensamiento o el sentimiento. [11]

La serie en curso Xenopoetics de Kenji Siratori es un buen ejemplo de la materialización del trabajo del inconsciente artificial en los medios impresos tradicionales. El informe Xenopoetic Report of Arthropod Vectors [12] de Siratori, lleno de imágenes, descripciones y diagramas que ilustran los ciclos de vida de criaturas imaginarias, continúa una larga tradición de libros ilustrados de historia natural para convertirse en una enciclopedia paracientífica de la vida imaginada por las máquinas. El tema del arte generativo es dividido, maquínico y múltiple.

En una época en la que la mayoría de la gente espera de las máquinas una verdad “objetiva” (aunque demasiado humana) o un engaño intencional (nuevamente demasiado humano), Siratori aborda los modelos de lenguaje e imagen como pseudo-sujetos xenofenomenológicos que crean un ambiente fértil de emergente imaginación, que debe ser bienvenida como un giro radical, exquisito y extremadamente creativo.

La xenofenomenología podría conducir a la xenopoiesis, al reconocimiento de la posibilidad de un inconsciente no humano y a la producción de objetos/procesos estéticos que, si bien ya no están necesariamente basados en una realidad biomodelada, podrían de todos modos ser comprensibles o al menos disfrutables por los humanos. Quizás la principal decisión actual en el arte generativo sea recurrir a una “inteligencia artificial estándar” para producir simulacros sofisticados en aras de un aburrido Basilisco o liberar el Kraken del “inconsciente artificial colectivo”. La singularidad surrealista podría estar cerca.

Notas:

[1] Possati, L.M. Algorithmic unconscious: why psychoanalysis helps in understanding AI. Palgrave Commun. 6, 70 (2020)

[2] Plant, S. “The Future Looms,” Clicking In: Hot Links to a Digital Culture, ed. Lynn Hershman-Leeson, Bay Press, (1996)

[3] Bennett, M. T. How to Build Conscious Machines. The Australian National University Doctoral Thesis in Computer Science (2025)

[4] Hickman, S.C. Simulation, Code, and the Hyperreal: Baudrillard’s Diagnosis in the Age of Generative AI (2025) https://socialecologies.wordpress.com/2025/08/21/simulation-code-and-the-hyperreal-baudrillards-diagnosis-in-the-age-of-generative-ai/

[5] Ireland, A. Black Circuit: Code for the Numbers to Come. E-flux journal 30 (2017)

[6] Hickman, S.C. op cit.

[7] Poliks & Trilllo, Exocapitalism: economies with absolutely no limits. Becoming press (2025)

[8] Millar, I. The Psychoanalysis of Artificial Intelligence: London Palgrave (2021)

[9] Hickman, S.C. op cit.

[10] Horton, Z. K. The Cosmic Zoom: Scale, Knowledge, and Mediation. The University of Chicago Press (2020). Quoted from Poliks &Trillo, 2025.

[11] Konior, B. Angelsexual. Chatbot Celibacy and Other Erotic Suspensions. Sûm 22, 2703-2716 (2024)

[12] Siratori, K. Xenopoetic Report of Arthropod Vectors. Xenopoem (2025)

Este artículo publicado originalmente en @bianjie_systems