Los datos incómodos de Facebook sobre la desinformación

Jinhwa Oh | The New York Times

Al comienzo de la pandemia, un grupo de analistas de datos de Facebook tuvo una reunión con ejecutivos para solicitar recursos que contribuyeran a medir la prevalencia de la desinformación sobre la COVID-19 en la red social.

Los analistas dijeron que saber cuántos usuarios de Facebook habían visto información falsa o engañosa sería complejo y que tal vez tomaría un año o más descifrarlo, según dos personas que participaron en la reunión. Pero añadieron que si se hacían algunas nuevas contrataciones para el proyecto, y se reasignaban algunos empleados, la compañía podría comprender mejor cómo los datos incorrectos sobre el virus se propagaban en la plataforma.

Los ejecutivos nunca aprobaron los recursos y al equipo nunca se le informó la razón, según los involucrados, quienes solicitaron mantener su anonimato porque no están autorizados para conversar con periodistas.

Ahora, más de un año después, Facebook se ha visto envuelto en una inmensa controversia por el mismo tipo de información que los analistas de datos querían rastrear.

La Casa Blanca y otras agencias federales estadounidenses han presionado a la compañía para que entregue datos sobre cómo se difunden en línea las historias contra las vacunas y han acusado a Facebook de retener información clave. El viernes 16 de julio, el presidente de Estados Unidos, Joe Biden, acusó a la compañía de “matar personas” al permitir que la información falsa circule de manera generalizada. El lunes 19 de julio, suavizó un poco el tono y prefirió responsabilizar a las personas que originan las mentiras.

“Cualquiera que esté escuchando eso, está siendo perjudicado”, dijo Biden, quien agregó que esperaba que en vez de “tomárselo de manera personal”, Facebook “haría algo con respecto a la desinformación”.

La compañía ha respondido con estadísticas que muestran cuántas publicaciones con desinformación ha eliminado, así como la cantidad de estadounidenses a los que les ha dirigido información real sobre la respuesta del gobierno a la pandemia. En una publicación en su blog el sábado 17 de julio, Facebook le pidió al gobierno de Biden que dejara de “señalar responsables” y de culpar a Facebook tras no haber cumplido su objetivo de vacunar al 70 por ciento de los adultos estadounidenses para el 4 de julio.

“Facebook no es la razón por la que no se logró ese objetivo”, dijo en la publicación Guy Rosen, vicepresidente de integridad de Facebook.

Pero el altercado tocó una fibra incómoda para la empresa: en realidad desconoce muchos detalles sobre cómo se ha propagado la desinformación sobre el coronavirus y las vacunas para combatirlo. Ese punto ciego ha reforzado las preocupaciones entre los investigadores de la desinformación sobre la selectiva liberación de datos de Facebook y cuán agresivamente —o no— la compañía ha analizado la desinformación en su plataforma.

“La insinuación de que no hemos invertido recursos para combatir la desinformación sobre la COVID-19 y apoyar la campaña de vacunación simplemente no está respaldada por los hechos”, dijo Dani Lever, una portavoz de Facebook. “Sin una definición estándar de lo que significa desinformación sobre vacunas, y con contenidos falsos e incluso verdaderos (a menudo compartidos por los principales medios de comunicación) que potencialmente desalientan la aceptación de la vacuna, nos enfocamos en los resultados: medir si las personas que utilizan Facebook están aceptando las vacunas contra la COVID-19”.

Los ejecutivos de Facebook, incluyendo a su director ejecutivo, Mark Zuckerberg, han dicho que la compañía se comprometió a eliminar la desinformación sobre la covid cuando comenzó la pandemia. La empresa dijo que había eliminado más de 18 millones de piezas de desinformación sobre la COVID-19 desde el inicio de la pandemia.

Los expertos que estudian la desinformación dijeron que la cantidad de piezas eliminadas por Facebook no era un dato tan informativo como la cantidad que había sido subida al sitio o en qué grupos y páginas las personas veían la propagación de la desinformación.

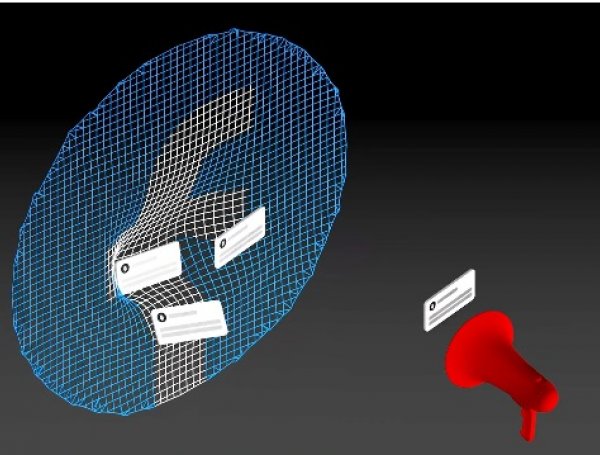

“Tienen que abrir esa caja negra sobre su clasificación de contenido y la arquitectura de amplificación de contenido. Deben llevar esa caja negra para que investigadores independientes y el gobierno la auditen”, afirmó Imran Ahmed, director ejecutivo del Centro para Contrarrestar el Odio Digital, una organización sin fines de lucro que tiene como objetivo combatir la desinformación. “No sabemos cuántos estadounidenses han sido infectados con desinformación”.

Utilizando datos disponibles públicamente de CrowdTangle, un programa propiedad de Facebook, el grupo de Ahmed descubrió que 12 personas eran responsables del 65 por ciento de la desinformación sobre la COVID-19 en Facebook. La Casa Blanca, incluyendo a Biden, repitió esa cifra la semana pasada. Facebook afirma no estar de acuerdo con la caracterización de “los doce de la desinformación”, además de asegurar que algunas de esas páginas y cuentas ya fueron eliminadas, mientras que otras ya no publican contenido que viole las reglas de Facebook.

Renée DiResta, investigadora de desinformación del Observatorio de Internet de la Universidad de Stanford, le hizo un llamado a Facebook para que divulgue datos más detallados porque eso le permitiría a los expertos comprender cómo las falsas afirmaciones sobre la vacuna afectan a comunidades específicas dentro de Estados Unidos. La información, conocida como “datos de prevalencia”, en esencia analiza qué tan difundida está una historia como, por ejemplo, el porcentaje de personas que la ve en una comunidad dentro de la plataforma.

“La razón por la que se necesitan datos de prevalencia más detallados es que las falsas afirmaciones no se propagan de la misma manera en todas las audiencias”, dijo DiResta. “Para poder contrarrestar de manera efectiva afirmaciones falsas específicas que están siendo vistas por las comunidades, las organizaciones de la sociedad civil y los investigadores necesitan tener una idea más clara de lo que está sucediendo dentro de esos grupos”.

Muchos empleados de Facebook han presentado el mismo argumento. El 18 de julio, Brian Boland, un exvicepresidente de Facebook que estaba a cargo de la estrategia de alianzas, le dijo a CNN que mientras estuvo en la compañía había planteado la idea de que Facebook debía compartir públicamente toda la información posible. Cuando se le preguntó sobre la disputa con la Casa Blanca por la desinformación referente a la COVID-19, Boland afirmó: “Facebook tiene esos datos”.

“Ellos ven los datos”, dijo Boland. Y luego agregó: “¿Los analizan de la manera adecuada? ¿Están invirtiendo en los equipos de manera tan ambiciosa como deberían?”.

Los comentarios de Boland fueron ampliamente citados como evidencia de que Facebook tiene los datos solicitados, pero ha decidido no compartirlos. Boland no respondió a una solicitud de comentarios de The New York Times, pero uno de los analistas de datos que presionó dentro de Facebook para que se hiciera un estudio más profundo sobre la desinformación del coronavirus dijo que el problema se centraba más en si la compañía había estudiado (y de qué manera) los datos.

Técnicamente, dijo la persona, la empresa tiene datos de todo el contenido que se mueve a través de sus plataformas. Pero medir y rastrear la desinformación sobre la COVID-19 requiere definir y etiquetar lo que califica como desinformación, algo a lo que, según la persona, la compañía no había dedicado recursos.

Algunos en Facebook han sugerido que el gobierno estadounidense, o los funcionarios de salud, deberían ser los que definan qué es la desinformación. Solo una vez que se establece esa base crucial, los científicos de datos pueden comenzar a diseñar sistemas conocidos como calificadores, que miden la difusión de información específica.

Debido a los miles de millones de piezas de contenido individuales que se publican todos los días en Facebook, el esfuerzo de medir, rastrear y, en última instancia, calcular la prevalencia de información errónea sería masivo, dijo la persona.

La reunión celebrada al inicio de la pandemia no fue la única vez que Facebook tuvo discusiones internas sobre cómo rastrear la información falsa.

Los integrantes del equipo de comunicaciones de Facebook también plantearon la cuestión de la prevalencia, y el verano y otoño pasados les dijeron a los ejecutivos que sería útil para disputar los artículos de periodistas que usaron CrowdTangle para reportear sobre la propagación de información errónea contra las vacunas, según un trabajador de Facebook involucrado en esas discusiones.

Después de las elecciones presidenciales de 2016, Zuckerberg buscó una estadística similar sobre la cantidad de “noticias falsas” que los estadounidenses habían visto antes, dijo un miembro del equipo de comunicaciones de Facebook. Una semana después de la elección, Zuckerberg publicó una entrada en un blog en la que decía que las noticias falsas llegaban a “menos del 1 por ciento”, pero la empresa no aclaró esa estimación ni dio más detalles a pesar de haber sido cuestionada por reporteros.

Meses después, Adam Mosseri, un ejecutivo de Facebook que entonces era el director de NewsFeed, dijo que parte del problema era que “las noticias falsas significan cosas distintas para diferentes personas”.

Davey Alba y Zolan Kanno-Youngs colaboraron con este reportaje.

Sheera Frenkel cubre temas de seguridad cibernética desde San Francisco. Antes pasó más de una década en Medio Oriente como corresponsal, reportando para BuzzFeed, NPR, The Times of London y McClatchy Newspapers. @sheeraf